9 月 13 日,OpenAI 发布 o1 模型

9 月 13 日,OpenAI 发布 o1 模型

一、出人意料的发布

北京时间 9 月 13 日凌晨,OpenAI 震撼推出了他们最新的 AI 模型。令人意外的是,这次并非大家期待的 GPT-5,而是全新的 o1。为了突出这一重大变革并与以往的模型区分开来,OpenAI 放弃了沿用已久的 “GPT” 前缀,采用了更简洁的命名——“o1”或“OpenAI-o1”,而非 “GPT-o1”,以彰显此次技术跨越的非凡意义。

这次发布十分突然,之前没有任何预兆。现在,付费用户已能体验o1-preview(预览版)和o1-mini(mini版),而完整版尚未对外开放。对于大众用户来说,o1模型的变化就像从与文科生对话转变为与理科生对话。之前的模型在翻译、摘要和总结上表现良好,但面对复杂的数学或物理问题时,可能会给出流畅但错误的答案。

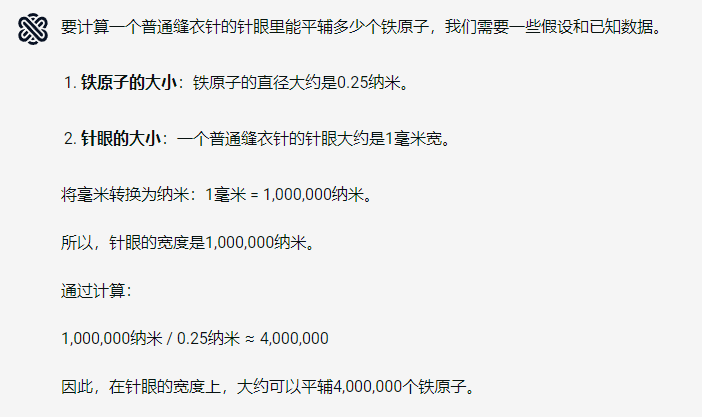

当你向以前的模型提问“一个缝衣针的针眼里能平辅多少铁原子?

相比之下,o1在处理类似问题时,会逐步展示思考和推理过程,计算思路显得更为准确。这样的能力提升让用户能够更清晰地理解问题的解决方案。

当你向 OpenAI-o1 提问“一个缝衣针的针眼里能平辅多少铁原子?

当你向 OpenAI-o1 提问“一个缝衣针的针眼里能平辅多少铁原子?

普通大众对o1在回答问题时的深思熟虑表示赞叹,而许多专业人士则关注一个名为“Scaling Law”的规律。这一术语尚无确定翻译,可称为“规模定律”或“规模缩放定律”。

二、Scaling Law:AI界的摩尔定律

Scaling Law揭示了深度学习能力与规模之间的基本规律,对AI行业而言,类似于集成电路领域的摩尔定律。自2019年起,这一规律一直指导着AI的发展,OpenAI尤其对此深信不疑。如果将Scaling Law视为AI领域的摩尔定律,OpenAI则可视为该领域的Intel。该术语源自标度理论,用于描述和预测复杂系统在不同规模下的行为,核心内容是性能指标与规模之间的幂律关系。

幂律分布示意图(可见长尾效应)

幂律分布示意图(可见长尾效应)

例如,在物理学中,系统在相变点附近时,其某些物理量会随着系统规模的变化而呈现幂律关系。在网络科学中,节点的度分布常常遵循幂律分布;在生物学中,动物的代谢率与体重之间也存在幂律关系;在城市科学中,城市规模与GDP、犯罪率、疾病传播等指标之间同样表现出幂律关系。

在人工智能领域,Scaling Law指的是模型的错误率与其规模之间呈现幂律关系,而且这一关系不依赖于具体的模型和算法细节。

Scaling Law 示意

Scaling Law 示意

与摩尔定律一样,Scaling Law也是从经验中总结出的规律,但两者有所不同。摩尔定律体现的是指数增长,效能随着时间翻倍增加;而Scaling Law则是幂律下降,效能的提高与成本的数量级成比例,而非线性关系。换句话说,Scaling Law表现出较差的投入产出比,但这仍然是深度学习模型能够达到的最佳效果。

摩尔定律

摩尔定律

深度学习的Scaling Law最早是在2017年由百度硅谷研究院发表的一篇论文中提出的,论文中提到模型的错误率与数据规模之间存在幂律关系。虽然这只是Scaling Law的初步探索,但为后续研究奠定了基础。

“Deep Learning Scaling is Predictable, Empirically”

“Deep Learning Scaling is Predictable, Empirically”

三、从GPT-3到GPT-4

真正让Scaling Law的价值得以发挥的是OpenAI。在2020年1月,OpenAI发表了一篇论文,指出大语言模型的错误率不仅与数据规模呈幂律关系,还与计算规模和参数规模之间存在类似的幂律关系。这一发现进一步深化了我们对深度学习模型性能的理解。

大语言模型的错误率和数据规模、计算规模、参数规模有幂律关系

大语言模型的错误率和数据规模、计算规模、参数规模有幂律关系

在这篇论文中,OpenAI提到的规模最大模型参数为1.5B(15亿),训练时间需要每秒千万亿次的计算持续10天,即10 petafloat-days (PF-days)。当时,这需要约33个英伟达V100 GPU。

如果模型规模扩大100倍,训练时间的计算也很快得到了答案。2020年6月,OpenAI发布了GPT-3,参数规模为175B。根据后来的估算,训练GPT-3大约花费了92天,使用的设备是微软提供的超级计算机,配备了10000个V100 GPU。这些数据继续遵循Scaling Law的规律。

GPT-3 的曲线也遵循 Scaling Law

GPT-3 的曲线也遵循 Scaling Law

尽管这篇论文是GPT-3发布后的事后总结,OpenAI很可能早在之前就已开始利用Scaling Law规划其发展。在GPT-3发布前一年,OpenAI打破了非营利组织的性质,转变为有限利润公司,并改变了模型的开源策略。特别是在2019年7月,微软向OpenAI投资了10亿美元,双方合作在Azure云计算服务上训练最新的大语言模型,即GPT-3。这一系列变化为OpenAI的发展奠定了基础。

这次战略调整确实非常冒险,最终导致了2023年底首席科学家伊利亚联合董事会罢免CEO奥尔特曼的事件,几乎使OpenAI面临分崩离析的危机。同时,OpenAI不再开源的决定也让其处于舆论劣势,被戏称为“ClosedAI”。

那么,是什么促使奥尔特曼下定决心做出如此巨大的改变?是什么让他相信只需10亿美元就能训练出下一代大语言模型?又是什么让他对下一代模型的能力充满信心?

现在来看,这些决策可能与OpenAI在2020年1月论文中提到的Scaling Law密切相关。Scaling Law为OpenAI提供了对未来模型性能和所需资源的深刻洞察,使他们能够在未实际训练模型之前就预测所需的投入和可能的产出。

现在看来,OpenAI在2020年1月论文中提到的Scaling Law可能是其决策的重要依据。类似于摩尔定律在芯片行业的作用,Scaling Law在AI领域也展现出预测未来产品规模和规划资源配置的潜力。以OpenAI为主导,业内人士可以利用Scaling Law评估未来的投入和产出,甚至在模型训练前预测达到特定效果所需的显卡数量,以及相应的股权释放和投资需求。这使得战略规划更加科学和高效。

四、Scaling Law失效?

不过,Scaling Law与摩尔定律也有明显不同。摩尔定律持续了几十年,最近几年才出现失效的讨论;而关于Scaling Law失效的讨论则显得更为提前。2020年1月,在OpenAI的论文中,错误率与规模的图像在对数坐标中仍未显示出拐点(幂律图像在对数坐标中应为一条直线)。这让人们期待,随着规模的增加,错误率能够逐渐接近0。

错误率和规模的图像在对数坐标中看不到拐点

错误率和规模的图像在对数坐标中看不到拐点

然而,仅仅过了10个月,2020年11月,OpenAI在另一篇论文中就挑战了Scaling的有效性。该研究显示,图像模型和视频模型的错误率随着规模增加存在一个无法消除的下限,而不是能够接近于0。换句话说,规模的增加对模型能力的提升存在天花板,这一发现对Scaling Law的应用提出了重要的警示。

图像模型、视频模型的错误率并不可以接近于 0

图像模型、视频模型的错误率并不可以接近于 0

尽管这篇论文为大语言模型留下了一线希望,因为尚未观察到明显的拐点,但这并不意味着大语言模型的收益可以随着规模的增加而无限增长。2022年3月,谷歌的DeepMind团队发表的一篇论文指出,即使是大语言模型,在规模达到某个极限时,也存在一个无法消除的下限。对于像GPT-3这样千亿级别的参数规模,这个下限可能暂时无需考虑,但是否值得投入更多成本以训练更大规模的模型仍然没有明确结论。

Deepmind 团队论文截图

Deepmind 团队论文截图

不清楚OpenAI是否有Scaling Law失效的顾虑,但GPT-3.5的参数规模仅略微增加,从175B提高到约200B。GPT-3.5更多是优化了自然语言和代码生成能力,这为OpenAI推出第一个爆款应用ChatGPT奠定了基础。ChatGPT于2022年11月30日发布,标志着AI元年的开端,各大厂商纷纷开始布局自己的大模型。

在人们还未来得及思考Scaling Law是否已在失效边缘时,OpenAI在2023年3月发布了GPT-4。虽然OpenAI没有公开GPT-4的技术细节,但业内人士估计其参数规模已达到1000B,较GPT-3扩大了近10倍,而训练成本则增加了近100倍。在GPT-4的技术报告中,OpenAI再次强调,在训练之前他们就根据Scaling Law预测了模型的最终表现,实际结果显示他们的预测非常准确。

从ChatGPT到GPT-4仅用了3个多月的时间,这让人对OpenAI根据Scaling Law进行的下一次升级产生了期待。然而,令人失望的是,在此期间仅发布了一个较小的更新——GPT-4o。虽然有关于内部项目Q*和“草莓”的流言,也就是GPT-5的传闻,但在过去一年多的时间里,OpenAI的表现确实让人感到失望。

五、寻找新增长模式

与此同时,其他厂商加快了追赶的步伐,先是Anthropic公司的Claude 3 Sonnet,接着是Meta的Llama 3,越来越多的大语言模型在性能上赶上了GPT-4。在这一过程中,GPT-4为何能在如此庞大的规模下仍能匹配Scaling Law的奥秘逐渐被揭示。如果仅仅依靠增加参数规模和堆积更多的训练算力,在1000B参数的规模下继续匹配Scaling Law将变得非常困难。

Claude 3 Sonnet

Claude 3 Sonnet

GPT-4能够实现这一点,主要依赖于在模型训练之外的优化,分为“训练前”(pre-training)和“训练后”(post-training)两部分。

“训练前”指的是对数据的预处理,以便模型能够更好地读取和理解。GPT-4引入了多模态功能,能够处理文本和图像输入,从而使训练数据更加丰富。

“训练后”则涉及对模型的微调。GPT-4采用了“基于人类反馈的强化学习”(RLHF),减少了不当内容响应的概率,提高了生成事实性内容的能力。这些优化使得GPT-4在性能上得以突破,尽管参数规模庞大。

不过,训练前和训练后的优化所带来的性能提升终究是有限的。否则,OpenAI不会在一年多的时间里没有公布新模型,而其他团队的模型即便超越了GPT-4,也并未显著领先。

许多业内人士明白,虽然Scaling Law可能还未失效,但要想继续匹配Scaling Law,就需要寻找新的增长模式。这意味着,单靠参数规模和训练算力的增加已经不足以满足未来的发展需求,创新的训练方法和模型架构将变得愈发重要。

李开复评价 Scaling Law

李开复评价 Scaling Law

六、o1思维链:AI新增长模式?

o1中的思维链(CoT)或许正是这个新增长模式的代表。o1发布后,OpenAI研究员Noam Brown在社交媒体上直接称其为匹配Scaling Law的新范式。这种方法通过引导模型进行逐步推理,可能帮助提升其在复杂任务中的表现,为模型的进一步发展开辟了新的路径。

OpenAI 研究员将思维链(CoT)称为匹配 Scaling Law 的新范式

OpenAI 研究员将思维链(CoT)称为匹配 Scaling Law 的新范式

思维链对普通用户而言,就是让AI模型能够分步骤思考,每个步骤的反思都能提高最终回答的准确性,从而提升模型的整体能力。思维链被称为维持Scaling Law的新范式,因为这一能力的提升不依赖于模型的训练过程,而是依赖于模型训练完成后的推理过程(Inference)。

在o1之前,大语言模型规模增长主要带来了训练成本的增加;而思维链则可以将传统的Training-Time Scaling模式转化为Inference-Time Scaling。这种转变使得在不大幅增加训练成本的情况下,依然能够提升模型的性能,展示出新的增长潜力。

o1 概念图

o1 概念图

在o1发布后,英伟达的高级研究经理Jim Fan直接将其称为Inference-Time Scaling范式。这一命名强调了思维链在推理过程中对模型性能的提升,使得模型在保持高效的同时,能够更好地应对复杂任务,展现出新的发展方向。

英伟达高级研究经理将 o1 称为 Inference-Time Scaling 范式

英伟达高级研究经理将 o1 称为 Inference-Time Scaling 范式

训练完成之后的推理过程(Inference)大幅增长

训练完成之后的推理过程(Inference)大幅增长

o1带来的模式转化,不仅为Scaling找到新的增长模式,还可能改变算力的成本分配。训练过程必然在服务器端完成,因此训练的算力成本完全由模型开发者承担;而推理过程则可以在用户自己的手机和电脑上完成,算力成本可以由用户承担。

当然,o1是否真的代表着AI迎来了新增长模式,我们现在还需保持期待,得出结论还为时尚早。相信未来会有更多相关研究,我们科技联播也会持续关注。

这就是本期关于OpenAI最新发布的o1模型的深度解读,希望你能有所收获,咱们下期再见!

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则